Hierarchical Multimodal Fusion for Ground Based Cloud Classification in Weather Station Networks

Hierarchical Multimodal Fusion for Ground-Based Cloud Classification in Weather Station Networks

Recently, the multimodal information is taken into consideration for ground-based cloud classification in weather station networks, but intrinsic correlations between the multimodal information and the visual information cannot be mined sufficiently. We pr

ieeexplore.ieee.org

이거 내가 옛날에 읽었던 거더라,, 정리좀 해놀걸 ㅠ^ㅠ

그래두 한번 읽고 끄적여놔서 금방 끝낼듯 아자아자

논문정리

Abstract

최근 기상관측 네트워크에서 지상기반 구름 분류를 위해 멀티모달 정보를 활용하고 있다.

하지만 멀티모달 정보와 이미지 정보간의 본질적인 상관성을 제대로 추출할 수 없음.

본 연구진은 지상기반 구름 분류를 위해 계층적 멀티모달 융합(HMF - Hierarchical Multimodal Fusion)을 제안하였다.

이는 여러 레벨에서 심층 멀티모달 특징과 심층 이미지 특징을 융합한다.

저레벨 융합, 고레벨 융합

- 저레벨 융합은 말그대로 이질적인 특징을 융합하여 modality에 특화된 융합에 초점을 둔다.

- 고레벨 융합은 저레벨 융합의 출력과 심층 이미지 특징, 심층 멀티모달 특징을 융합한다.

심층 융합구조 덕에 그들간의 복잡한 상관관계를 더 학습할 수 있음

HMF의 전체구조를 학습할 수 있는 손실함수를 도입하여 구름 표현에서의 차별점을 향상시킬 수 있도록 하였다.

MGCD 데이터셋에 대한 실험결과는 해당 방법이 다른 방법들을 능가함을 보이면서 지상기반 구름 이미지에서 HMF의 효과를 입증한다.

Introduction

최근에는 기상관측 네트워크에서 지상 기반 구름 이미지를 분류하는 것이 중요해졌다.

- 운형이 기상조건의 중요한 지표가 되기 때문에 기상 관측에서 응용

- 구름은 전자기파와 광파를 전달하는데 영향

하지만 구름을 분류하는 것은 주로 인간의 관측에 의해 이뤄지는데 이는 시간도 많이 소요되고 주관적이다.

따라서 지상기반 구름 분류를 위한 자동화 기술의 개발이 시급하다.

지상기반 구름 이미지를 활용하여 구름 표현으로부터 이미지 정보를 추출하기 위한 접근법이 많다.

두가지 이유가 있다.

- 지상 기반 구름 이미지를 획득하기 위한 장비가 발명되어 고품질의 지상 기반 구름 이미지를 쉽게 얻을 수 있다.

- 컨볼루션 신경망 (CNN)이 깊은 구조, 로컬 수용장, 공유 가중치, 공간 하위 샘플링 등을 활용하여 구름 이미지에 대해 강력한 특징 표현을 제공한다.

물론 CNN에서 추출한 심층 이미지 특징으로 좋은 성능을 얻을 수 있는건 맞지만, 그것만으로 구름을 완전하게 묘사할 순 없다.

구름의 형성이 멀티모달 정보인 온도, 습도, 압력, 풍속 등과 연관있기 때문이다.

한 연구는 멀티모달 정보와 시각적인 특징을 결합하여 구름을 표현하는 방법을 제안하였다.

구름 이미지와 멀티모달 정보는 이질적인 데이터이다.

구름 이미지는 텐서로, 멀티모달 정보는 벡터로 표현된다.

이질적 데이터를 융합하는 데는 두가지 전략이 있다.

- CNN으로 심층 시각 특징을 학습하고 멀티모달 원시 정보를 이어붙여서 (concatenate) 구름 이미지에 대한 최종 표현을 얻는다. ▶ 그림 1(a)

- 두 개의 모델로 각각 심층 시각 특징과 심층 멀티모달 특징을 추출하고 두 가지의 특징을 통합하기 위해 융합 연산을 시행한다. 하지만 현재의 융합 방법은 이미지와 멀티모달 정보의 부분적인 상관관계 정도만 포착할 수 있다.

본 논문에선 Hierarchical Multimodal Fusion(HMF)라는 새로운 접근법을 제안하여 구름 이미지를 분류한다.

제안된 HMF는 두개의 하위 네트워크를 가지고 있다.

시각 하위 네트워크, 멀티모달 하위 네트워크

각 정보는 다른 형태를 띠고 있지만 두개의 시각 하위네트워크, 멀티모달 하위 네트워크가 CNN과 MLP로 설계되어 있어서 이질적인 입력을 같은 차원의 특징벡터로 변형할 수 있다.

시각 정보와 멀티모달 정보의 복잡한 상관성을 학습하기 위해 HMF는 계층적인 융합 전략을 제안하여 저수준 융합과 고수준 융합을 진행한다.

저수준 융합은 심층 시각 특징과 심층 멀티모달 특징을 융합하며, 고수준 융합은 저수준 융합의 출력을 심층 시각특징, 심층 멀티모달 특징과 융합하여 복잡한 상관관계를 학습한다.

또한 FC 레이어를 두 개의 융합 레이어 사이에 추가하여 고수준 융합의 입력을 같은 차원으로 맞춰준다.

게다가, 심층 네트워크에 손실함수를 도입하여 이질적 차원의 서로 다른 수준의 융합을 동시에 최적화한다.

실험 결과는 제안된 HMF가 다른 SOTA 방법을 상당히 능가하였음을 보여준다.

제안된 HMF는 요약하면 다음과 같다.

(1) HMF는 이질적인 특징들 여러 수준에서 융합하여 시각정보와 멀티모달 정보간의 본질적인 상관관계를 학습

(2) HMF의 전체 프레임워크를 학습하기 위한 손실함수fmf 도입하여 구름 표현의 차별성을 향상

(3) 공개된 데이터셋 MGCD에 대한 실험 결과는 제안된 HMF의 효과를 입증

Related Work

skip

Approach

심층 특징 추출, 계측적 멀티모달 융합, 손실함수 특면에서 모델을 구체적으로 살펴 본다.

그림 2는 HMF의 프레임워크를 보여준다.

<Deep Feature Extraction>

Deep Visual Features

이질적인 특징들을 동시에 학습하기 위해서 HMF는 두개의 하위 네트워크를 사용한다.

시각적 하위 네트워크, 멀티모달 하위 네트워크

시각적 하위 네트워크는 지상기반 구름 이미지로부터 깊은 시각적인 특징을 추출하도록 정의되어 있다.

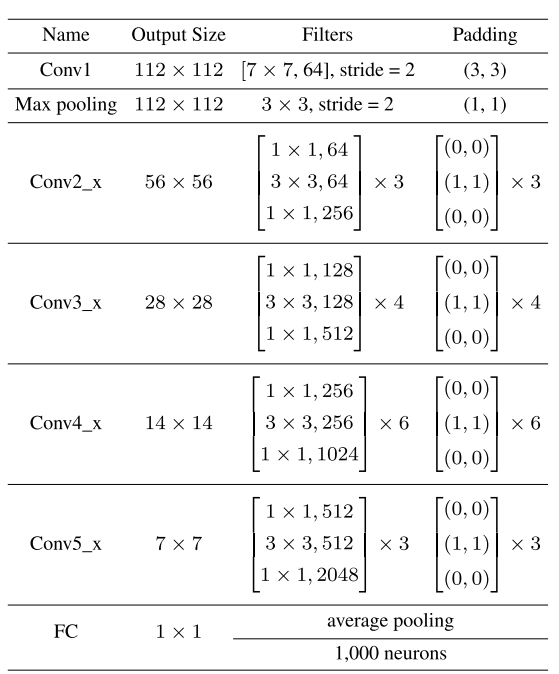

백본으로는 ResNet-50을 사용하였고, 표 1에서 ResNet-50의 구조를 확인할 수 있다.

Conv2_x ~ Conv5_x는 4 종류의 기본 잔여 블럭을 가지고 있어 총 16개의 빌딩 블럭이 있고, 여기서 각 빌딩 블록내에는 3개의 컨볼루션 층이 존재한다.

이때, 각 블럭의 컨볼루션 커널 크기는 1×1,3×3,1×1이다.

여기서 ResNet-50의 구조를 살짝 수정하여 제안된 융합 전략에 적용하였다.

최종 FC 층을 제거하고, 2048의 차원을 갖는 평균 풀링 레이어의 출력을 심층 시각 특징으로 간주함

심층 시각 특징은 시각 하위 네트워크의 깊은 구조 덕에 복잡한 비선형 구름 정보를 포함하고 있다.

Deep Multimodal Featues

구름의 멀티모달 정보는 구름 이미지와는 다른 각각의 다른 semantic 정보를 담고 있다.

따라서 두 정보의 결합을 통해 구름 이미지에 완전한 표현을 얻을 수 있다.

멀티모달 정보는 4가지가 있다.

온도, 습도, 압력, 풍속

즉, 하나의 구름 샘플은 한 장의 이미지와 4개의 멀티모달 정보로 이뤄져있는 셈

이 4가지의 멀티모달 정보를 하나의 벡터에 담았다.

벡터의 특징을 학습하기 위해 MLP로 멀티 모달 네트워크를 구성하였다.

MLP는 6개의 FC 층으로 구성되어 있으며, 뉴런 수는 각각 64, 128, 256, 512, 1024, 2048이다.

점점 늘어남

심층 시각적 특징과 호환될 수 있도록 마지막 층의 차원을 2048로 설정하였다.

멀티모달 하위 네트워크의 출력은 심층 멀티모달 특징으로 간주하고 이때 차원은 심층 시각적 특징과 같다.

<Hierarchical Multimodal Fusion>

멀티모달 구름 분류의 기존 방법은 주로 얕은 융합 전략을 적용하여 이질적인 특징 간 부분적인 상관관계만 포착한다.

이 한계를 극복하기 위해 HMF는 더욱 복합적인 관계를 포착할 수 있도록 제안한다.

특히 HMF는 여러 수준의 융합을 통해 이질적인 특징을 통합한다.

저수준 융합에서는, 심층 시각 특징과 심층 멀티모달 특징을 연결(concatenate)하는 방식으로 융합하여, 융합된 특징은 modality-specific.

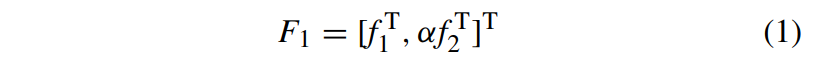

이를 고려하면 저수준 융합은 식 1과 같이 표현한다.

f1 : 심층 시각 특징

f2 : 심층 멀티모달 특징

[.,.] : concatenation 연산

α : 심층 모달리티 특징의 중요도를 표현할 양수값

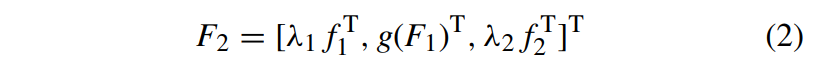

이후 둘 사이의 상관성을 더 포착하기 위해 식 2와 같이 고수준 융합 전략을 제안하여 저수준 융합 출력과 이질적인 특징들을 융합한다.

λ1,λ2 : 심층 시각 특징과 심층 멀티모달 특징의 정도를 결정할 가중치

g(⋅) : 차원 축소 연산 (F1이 f1,f2와 같아지도록 차원을 변형하며 2048개의 뉴런을 갖는 FC로 구현

제안된 HMF에서는 고수준 융합 특징 F2을 최종 표현으로써 구름 분류에 활용한다.

한마디로, 두 가지 특성이 있다.

- HMF는 심층 시각 특징과 심층 모달리티 특징을 여러번 융합하여 심층 융합의 개념이라 할 수 있으며 두 특징간의 복합적인 상관관계를 학습한다.

- HMF는 기존의 얕은 융합에 비해 상대적으로 깊은 구조를 가지고 있어 이질적인 특징으로부터 풍부한 semantic 정보를 더욱 깊게 얻어낼 수 있다.

<Loss Function>

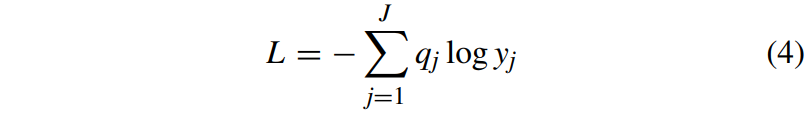

심층 시각 특징과 심층 모달리티 특징을 최적화하기 위해, 크로스 엔트로피 손실을 활용하여 HMF의 파라미터를 최적화 하였다.

크로스 엔트로피 손실은 운형별 예측된 확률 분포와 실제 확률 분포간의 유사도를 평가한다.

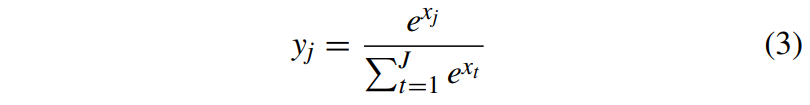

식 3은 예측된 확률 분포를 얻기 위한 소프트맥스 연산이다.

xj : 최종 FC층에서 j번째 뉴런의 출력값

J : 운형 수 (# of class)

yj∈[0,1] : j번째 운형 확률

식 4를 통해 크로스엔트로피 손실을 계산한다.

모든 k에 대해 qj=1일 때를 제외하고 g_k=0이다.(j$ : ground-truth 라벨)

훈련 단계에서는 SGD(STochastic Gradient Descent$를 옵티마이저로 사용한다.

Experimental Results

다른건 스킵하고 구현 세부사항만 보자.

<Impelemental Details>

훈련셋의 이미지는 224×224로 조정하고 각 픽셀에서 평균값을 빼고 표준편차로 나눠주는 식으로 정규화를 진행

[-25, 25] 범위 내에서 랜덤으로 회전시킨 후 랜덤으로 수평/수직 전환을 수행함

이때 확률은 50%

테스트셋 이미지는 똑같이 224×224로 조정하고 훈련셋과 똑같은 정규화 과정을 거친다.

멀티모달 정보는 모든 데이터를 [0,225] 범위로 정규화한다.

시각 하위 네트워크는 사전훈련된 ResNet-50로 초기화한다.

모든 FC층의 가중치는 표준정규분포를 따라 초기화되고, 편향의 초기값은 0으로 설정한다.

훈련 에폭은 50, 배치 크기는 32.

초기 학습률은 3×10−4로 세팅하다가 25, 45 에폭이 되면 초기 학습률의 0.2배로 감소한다.

구름 특징을 추출한 뒤에는 SVM(Soft Vector Machine)으로 구름을 분류한다.

Conclusion

본 논문에선 계층적 멀티모달 특징 융합 방법을 제시하여 구름 분류에 활용하였다.

시각적 하위 네트워크와 멀티모달 하위 네트워크를 가지며 각각 심층 시각 특징과 심층 멀티모달 특징을 학습한다.

두 특징간 더 깊은 상관정도를 포착하기 위해 계층적 융합 전략을 사용하여 여러 수준에서 이질적인 특징들을 융합하였다.

HMF을 훈련하기 위해 손실함수를 도입하여 구름 분류 이미지를 더 완벽히 표현할 수 있도록 하였다.

SOTA 방법에 비해, 제안된 HMF는 MGCD 데이터셋에 대해 좋은 성능을 보였고 구름 분류 작업에서의 효과를 입증하였다.

결국 두개의 네트워크를 사용해서 각각 사진과 데이터 정보를 학습하였고 이를 어떻게 잘 융합해서 구름에 분류했다는 얘기다.

그림 2를 보고 예상은 했지만 논문에서도 딱 예상한 그대로의 내용만 담고 있는 것 같다.

결국 두 특징을 1차로 concate하고 2차로 한번 더 concate한 거 아닌가?

simple is the best라고 단순할수록 성능이 좋은 건가 싶기도 하다.